#AI

Miért szexisták az algoritmusok?

A mindennapi életünket irányító algoritmusok túlnyomó többségét férfiakkal tesztelték. Milyen következményekkel jár ez a felhasználókra nézve? Ezzel foglalkozó szakértőt kérdeztünk.

A világot gyakran férfiak alakítják férfiaknak számára, egyre inkább hátrányos helyzetbe hozva ezzel az ellenkező nemű társaikat. Ez volt a helyzet a 19. században az ipari forradalommal, amely a nők nélkül zajlott, és sokáig távol tartotta őket ettől a területtől. A mesterséges intelligencia fejlődésével ez a probléma újra előtérbe került: a mindennapi életünk számos aspektusát irányító algoritmusok elfogultak, ahogyan azt Aude Bernheim és Flora Vincent kutatók is feltárják erről szóló könyvükben. Az arcfelismeréstől kezdve az autók légzsákrendszeréig mindent férfi modellek szerint számoltak ki, ami közvetlen hatással van a nők mindennapi életére. Az Elle újságírója Aude Bernheimmel, az Institut Pasteur doktorandusz hallgatójával beszélgetett.

Elle: Szerinted az algoritmusok szexisták?

Aude Bernheim: Igen! Másképp kezelik a „férfi” és a „női” információkat. A legszembetűnőbb példa erre is a fordítószoftverek, például a Google Translate működése: amikor az angol nyelvről a „nővér” szót valamilyen gendersemleges nyelvre fordítjuk, a rendszer automatikusan „ápolónő”-nek fordítja a szót, míg az „orvos” általában „doktor marad”. Az algoritmusok ilyen módon reprodukálják a társadalmunkban meglévő megkülönböztetéseket.

Elle: Minek köszönhető ez?

A.B.: Egy algoritmus kidolgozásának több szakasza van, és mindegyikhez előítéletek kötődhetnek. Amikor algoritmust építünk, azzal kezdjük, hogy felteszünk magunknak egy kérdést és kitűzünk egy célt. Például azt akarjuk, hogy az algoritmus képes legyen felismerni egy bizonyos számú átirat közül a legérdekesebbeket, hogy kiválassza a legjobb jelölteket az egyetemre. Ezért meg kell határoznunk, hogy a „legjobb” kifejezéssel milyen fajta diákot keresünk: az összes jegy átlagát nézzük, vagy a legjobb javulási lehetőséget? Egy meglehetősen általános jellegű vágy matematikai lefordításának ez a módja torzítást eredményezhet, mivel a kiválasztási módtól függően nem pontosan ugyanolyan típusú profilokat fogunk kiválasztani.

Ezután a második lépés az algoritmus betanítása. Adunk neki egy szöveghalmazt, hogy megtanítsuk felismerni, mire van szükségünk. Sok esetben ez az adatbázis nagyon elfogult lesz. A Google Translate szükségszerűen a „nővért” „ápolónőnek”, az „orvost” „doktornak” fogja fordítani, mert a neki tanulásra adott szövegekben az esetek túlnyomó többségében az „orvos” férfi nemű.

Végül az utolsó probléma: sok kódot újra felhasználnak egyik algoritmusból a másikba, még akkor is, ha azok elfogultak. Amint kijavítjuk ezeket az elfogultságokat, dominóhatást fogunk tapasztalni, és az azonos kódokat használó algoritmusok kevésbé lesznek elfogultak.

Elle: Hogyan lehet ezt orvosolni?

A.B.: Emberi és technikai megoldások keverékére van szükség. Az adatbázisok egyenlővé tétele technikai jellegű. Az emberi megoldás alatt azt értem, hogy az embereket is ki kell képezni az algoritmikus torzításainak felismerésére: ki kell képezni az algoritmusokat kódoló fejlesztőket, de a felhasználókat is. Ha egy munkaerő-felvételért felelős személy nézi át az önéletrajzokat, ő biztosan kapott már képzést a nemek közötti egyenlőtlenségekről és a felvételi torzításokról. Ha viszont egy algoritmust használ, és teljesen megbízik benne, akkor nem lesz elég éber. Míg ha jól kiképzik az adatok elemzésére, akkor képes lesz korrigálni ezeket az algoritmikus torzításokat.

Elle: Ezek az előítéletek összefüggésben állnak azzal a ténnyel, hogy az algoritmusokat készítő emberek túlnyomó többsége férfi?

A.B.: Az intuíció azt mondaná, hogy igen. Hogy miért? Amikor egy új terméket tesztelünk, akkor azt a körülöttünk lévő embereken teszteljük. Ha én készítek egy arcfelismerő alkalmazást, először magamon tesztelem, és ha nem működik, akkor megértem, hogy baj van. Most képzeljük el, hogy egy csapatban csak 20 és 50 év közötti fehér férfiak vannak. Akkor óhatatlanul fennáll a veszély, hogy az algoritmus kifejezetten erre a populációra vonatkozóan működik majd. Az ezeket az elfogultságokat bejelentők közül sokan olyan személyek, akik nem feleltek meg ezeknek az algoritmus-kritériumoknak, és technológiai zsákutcában találták magukat. A mesterséges intelligenciával kapcsolatban is vannak olyan munkák, amelyek azt mutatják, hogy ha a csapatok vegyesek, hajlamosak leszünk jobban figyelembe venni a nemi dimenziót.

Elle: Miért van kevesebb nő a mesterséges intelligencia területén?

A.B.: A tudományos területeken akad probléma a sokszínűséggel. Nagyon nemi alapú társadalom vagyunk, ami azt az elképzelést támogatja, hogy egyes munkakörök női, mások pedig férfi munkakörök. Ez különösen igaz az informatikára, ahol a fikciókban sok kulturális sztereotípia kapcsolódik a stréber figurájához, ami még inkább felerősíti ezeket az egyenlőtlenségeket. De facto az informatikát választó nők igen nagy kisebbségben vannak. Ez kulturális problémát okoz az iskolákban és a vállalkozásokban, és sok nőt kiszorít ezekről a területekről. Szerencsére vannak intézmények, amelyek elmozdítják a határokat, és évről évre több nőt vesznek fel. Most már csak azt kell megnéznünk, hogy a vállalati kultúra is fejlődik-e, és segít-e megtartani azokat a nőket, akik végre az informatika területére merészkednek!

Forrás: Elle

Neked ajánljuk

A ROVAT LEGNÉPSZERŰBB CIKKEI

Hihetetlenül magas az IQ-d, ha észreveszed a második állatot a képen

2022.07.29. 1 perc olvasásHihetetlenül magas az IQ-d, ha észreveszed a második állatot a képen

Kitalálod, melyik nő a kisfiú édesanyja? Sokat elárul rólad, rájössz-e a válaszra

2025.10.20. 2 perc olvasásKitalálod, melyik nő a kisfiú édesanyja? Sokat elárul rólad, rájössz-e a válaszra

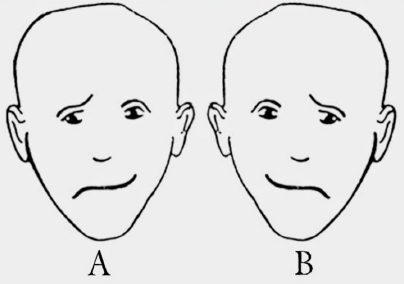

Melyik arcot látod vidámabbnak? A válaszod rengeteget elárul a személyiségedről

2023.01.24. 2 perc olvasásMelyik arcot látod vidámabbnak? A válaszod rengeteget elárul a személyiségedről

Egy zseni vagy, ha 13 másodperc alatt megtalálod a macskát a képen

2022.08.10. 1 perc olvasásEgy zseni vagy, ha 13 másodperc alatt megtalálod a macskát a képen

Csak egy született zseni találja meg a hibát a képen 7 másodperc alatt

2023.04.13. 1 perc olvasásCsak egy született zseni találja meg a hibát a képen 7 másodperc alatt

Szerinted ki a legokosabb a képen látható 4 ember közül? Érdekes dologról árulkodik

2022.09.06. 1 perc olvasásSzerinted ki a legokosabb a képen látható 4 ember közül? Érdekes dologról árulkodik

Ha 5 másodperc alatt kiszúrod a disznót a nyuszik között, igazán különleges vagy

2022.09.26. 1 perc olvasásHa 5 másodperc alatt kiszúrod a disznót a nyuszik között, igazán különleges vagy

Hány kutyát látsz a képen? Elárulja, hány éves vagy szellemileg

2025.10.17. 2 perc olvasásHány kutyát látsz a képen? Elárulja, hány éves vagy szellemileg

Ezek is érdekelhetnek

A közösségi média igazi veszélye: magány, AI-szerelem, empátia hiány

2025.10.09. 5 perc olvasásDanger

Megkérdeztem a ChatGPT-t, mit jelent az álmom – érdekes választ adott

2025.10.06. 6 perc olvasásAI

Az AI tényleg érzelmileg intelligensebb lehet az embereknél? Ez derült ki egy kutatásból

2025.09.09. 3 perc olvasásÉrzelmi intelligencia

Itt a 3 munkakör, amit szépen lassan felvált majd a mesterséges intelligencia

2025.08.30. 3 perc olvasásAI

Mesterséges intelligencia: ezt a szakmát tényleg felválthatja az AI?

2025.06.06. 2 perc olvasásWork

Íme a készségek, amiket a mesterséges intelligencia nem tud átvenni

2025.06.05. 2 perc olvasásAI

LinkedIn profil: ezt a hibát sose kövesd el, ha mesterséges intelligenciához fordulsz

2025.04.15. 2 perc olvasásHiba

Letarolta a netet az AI-Barbie: neked már van sajátod?

2025.04.15. 2 perc olvasásTrend

Az általad megtekinteni kívánt tartalom olyan elemeket tartalmaz, amelyek az Mttv. által rögzített besorolás szerinti V. vagy VI. kategóriába tartoznak, és a kiskorúakra káros hatással lehetnek. Ha szeretnéd, hogy az ilyen tartalmakhoz kiskorú ne férhessen hozzá, használj szűrőprogramot!